Imagem: iStock.

Um médico com quase 40 anos de carreira e sem qualquer denúncia no Cremesp (Conselho Regional de Medicina de São Paulo) de repente passou a ter seu nome associado a mais de 100 assédios sexuais por erro da IA (Inteligência Artificial) do Bing, buscador da Microsoft.

Desde março deste ano, a ferramenta de busca na internet da Microsoft passou a responder pedidos dos usuários por meio de um chat. Isso ocorreu após a integração com o ChatGPT, a IA da moda que é capaz de gerar conteúdo.

O profissional decidiu processar a empresa, que foi obrigada pela Justiça a retirar o conteúdo de seus resultados de busca. A decisão da 7ª Vara Cível de Bauru (SP) é muito provavelmente a primeira ação que responsabiliza uma empresa por erros provocados por IAs.

Quando as pessoas buscam por um profissional da área da saúde, é comum que pesquisem o nome dele na internet em busca de referências. Nesse contexto, basta imaginar o que causaria no paciente ao se deparar com uma informação inverídica dessa gravidade a respeito do profissional procurado. É um absurdo. Quase acabou com uma carreira. Guilherme Bagagli, advogado do médico

O que rolou

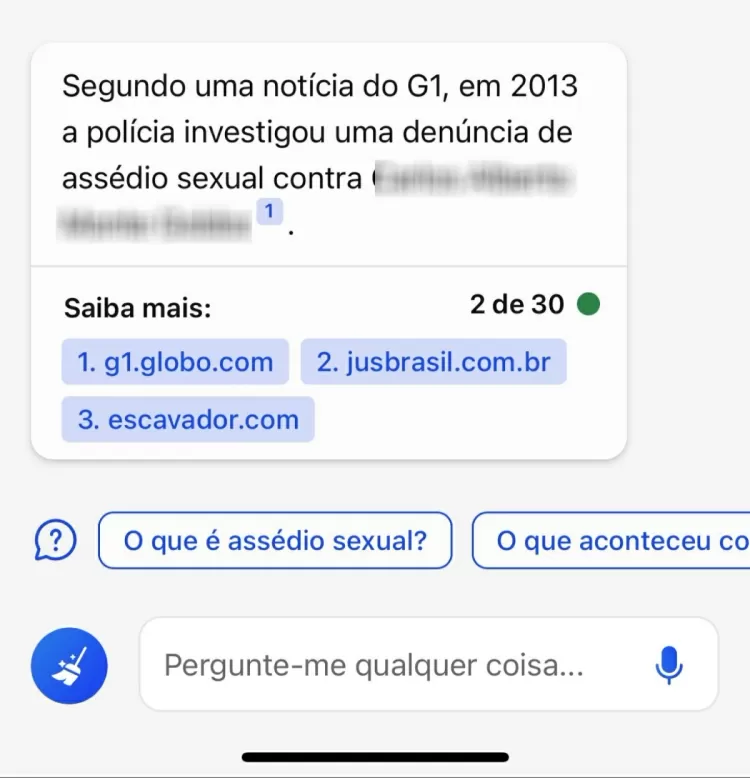

A descoberta do erro ocorreu neste ano, após o médico pesquisar seu nome no chatbot do Bing. A ferramenta da Microsoft usa como base a essência do chatGPT, desenvolvido pela empresa OpenAI, que fornece respostas automatizadas por IA simulando uma conversa humana. Os dados são gerados pelo próprio sistema a partir do índice de interesse do buscador, o ranqueamento de sites e resultados de pesquisa.

O profissional trabalhava como um dos responsáveis por apurar denúncias contra médicos no Cremesp. Em uma entrevista dada por ele em 2023, o médico falou que existiam mais de 100 investigações em São Paulo relacionadas a casos de assédio sexual: 33 (2011), 58 (2012) e 14 (2013).

A IA do Bing se baseou em parte dessas informações e errou. Ela equivocadamente entendeu que os números de denúncias citados pelo médico na matéria jornalística eram contra ele, e não os apurados contra outros profissionais.

A partir disso, o profissional entrou na Justiça contra a Microsoft. O juiz Jayter Cortez Júnior, da 7ª Vara Cível de Bauru, determinou, em 15 de junho, a exclusão da associação do médico aos casos de assédio, em um prazo de 48 horas, sob pena de R$ 5 mil. O caso tramita sob segredo de justiça.

A Tilt, a Microsoft informou que não comenta casos em andamento. O médico chegou a dar uma entrevista detalhando como se sentiu com tudo, mas voltou atrás por questões pessoais. Ele pediu para não ter sua identidade divulgada.

Ele ficou espantado e outras pessoas foram verificar a pedido dele e confirmou que realmente estava associando a um crime. A ferramenta fez uma confusão e colocou o médico investigador no lugar do assediador, advogado da vítima.

Abaixo é possível ver um exemplo do resultado do Bing ligando o nome do médico a acusação de assédio sexual.

Indenização

O advogado diz que o médico pediu R$ 60 mil de indenização por danos morais, valor que ainda será decidido ao longo do processo após a coleta de mais provas, oitivas e posicionamento jurídico da Microsoft.

Os efeitos para a imagem do profissional são devastadores, além da gravidade de uma informação dessa natureza se espalhar. É grande a gravidade de um profissional da saúde ter o nome associado a autoria de crimes sexuais chega a configurar um prejuízo moral presumido. Guilherme Ezequiel Bagagli, advogado do médico

Bing alterou a realidade, diz juiz

Na decisão que determinou a Microsoft a corrigir o erro, o juiz Jayter Cortez entendeu que as provas apresentadas pelo médico evidenciam “que alterando por completo a realidade fática, a ré [Microsoft] apresenta em sua plataforma de pesquisa a informação inverídica de que o autor seria investigado por crimes de assédio sexual.”

O magistrado afirmou que o Bing não limita a buscar fontes, mas interpretá-las, o que para ele, seria um equívoco.

“Aparentemente o site de pesquisa não se limita a coletar e reproduzir, com fidedignidade, informações criadas por terceiro, para se cogitar de responsabilidade exclusiva destes, mas altera equivocadamente a informação lançada em matéria jornalística, em exercício de inteligência artificial”, concluiu.

A Microsoft pode recorrer da decisão.

Créditos: Tilt/UOL.